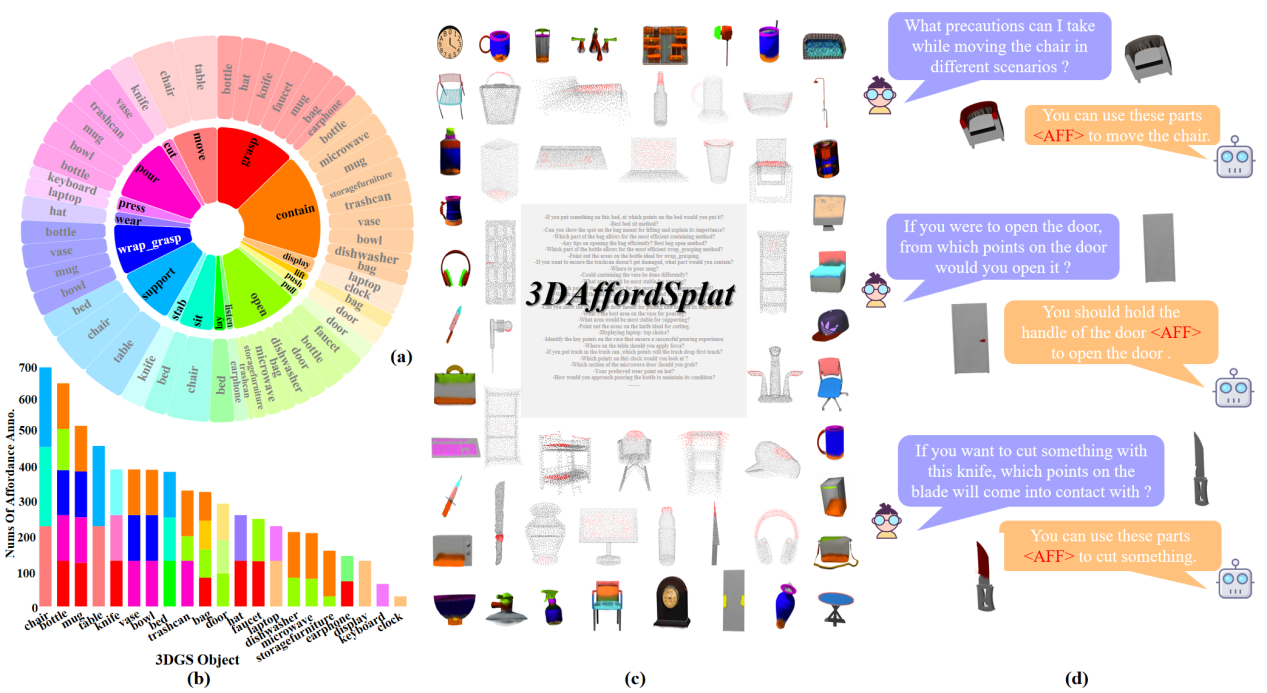

图1. 3DAffordSplat数据集概览图

鹏城实验室围绕 “数字中国”“东数西算”等国家重大战略,持续推进“中国算力网”的研发与建设工作。“中国算力网”旨在借助新一代通信和网络技术,实现国家大型算力的高速互联,构建起资源接入便捷、任务统一调度且具备可持续运营模式的数字经济基础设施。在这一体系中,数据是核心战略资源,算力网的高效运转离不开高质量数据的支撑,其愿景不仅是让用户像使用电力一样获取算力服务,更要实现数据的高效流通与价值挖掘。

在此背景下,近日,鹏城实验室联合中山大学等聚焦三维场景中可供性理解的关键难题,依托“中国算力网”构建的分布式算力集群与跨域数据协同平台,成功提出首个基于3D高斯泼溅表示的可供性数据集(3DAffordSplat数据集,见图1)及配套算法模型框架(AffordSplatNet模型)。该数据集的诞生,为“中国算力网”注入了新的核心数据资源。

借助“中国算力网”的算力支持,研究团队高效处理包含微观几何特征的密集型数据,精准捕捉到如织物纹理、金属划痕等影响可供性推理的关键细节,最终形成覆盖21类日常用品、包含18种典型交互模式的高质量标注数据集。这一数据集作为“中国算力网”中针对具身智能领域的特色数据储备,将为更多相关研究和应用提供核心驱动力。相关成果论文“3DAffordSplat: Efficient Affordance Reasoning with 3D Gaussians”已被多媒体领域顶级国际会议ACM International Conference on Multimedia (ACM MM) 2025接收,并将被推荐作口头报告(Oral)。

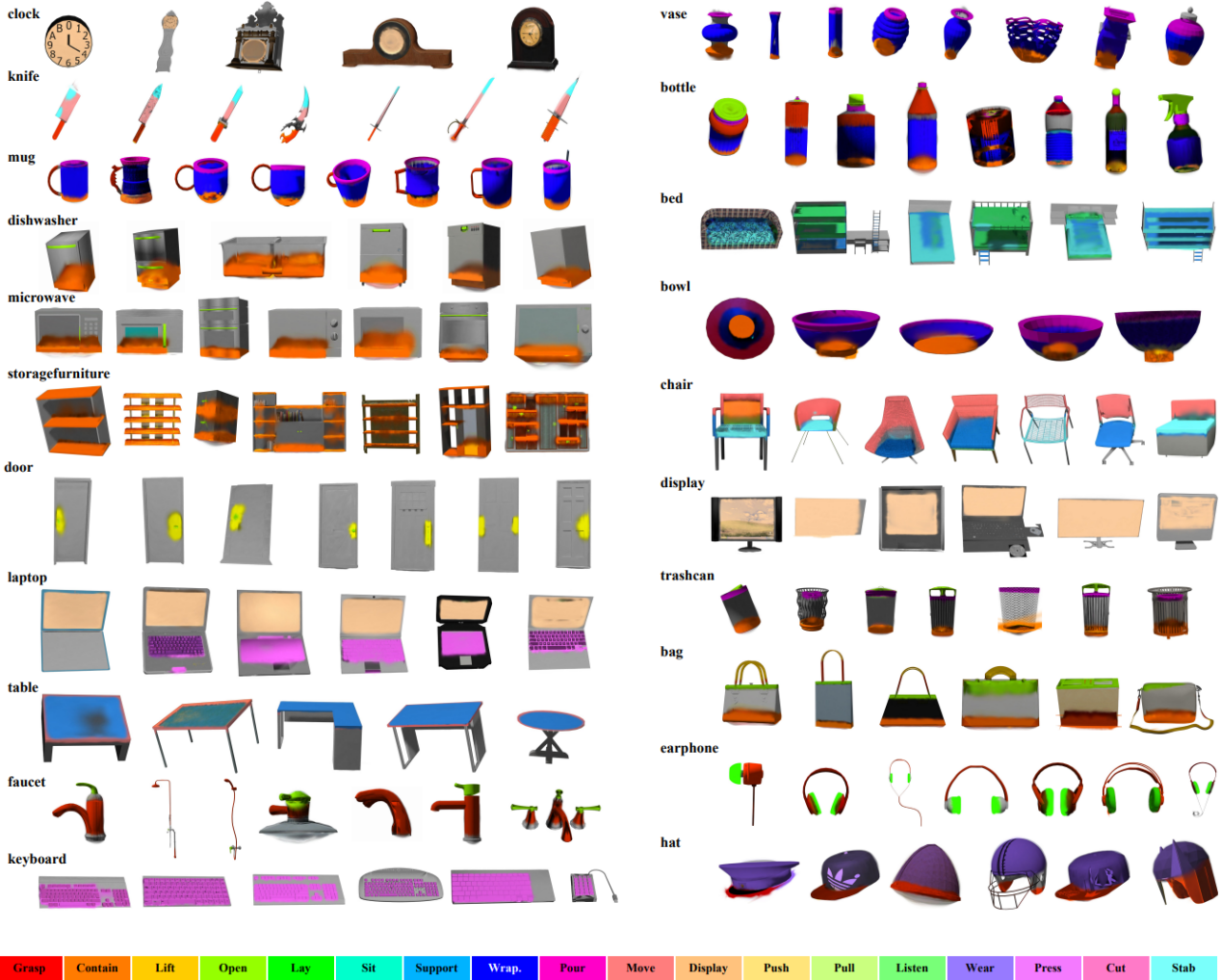

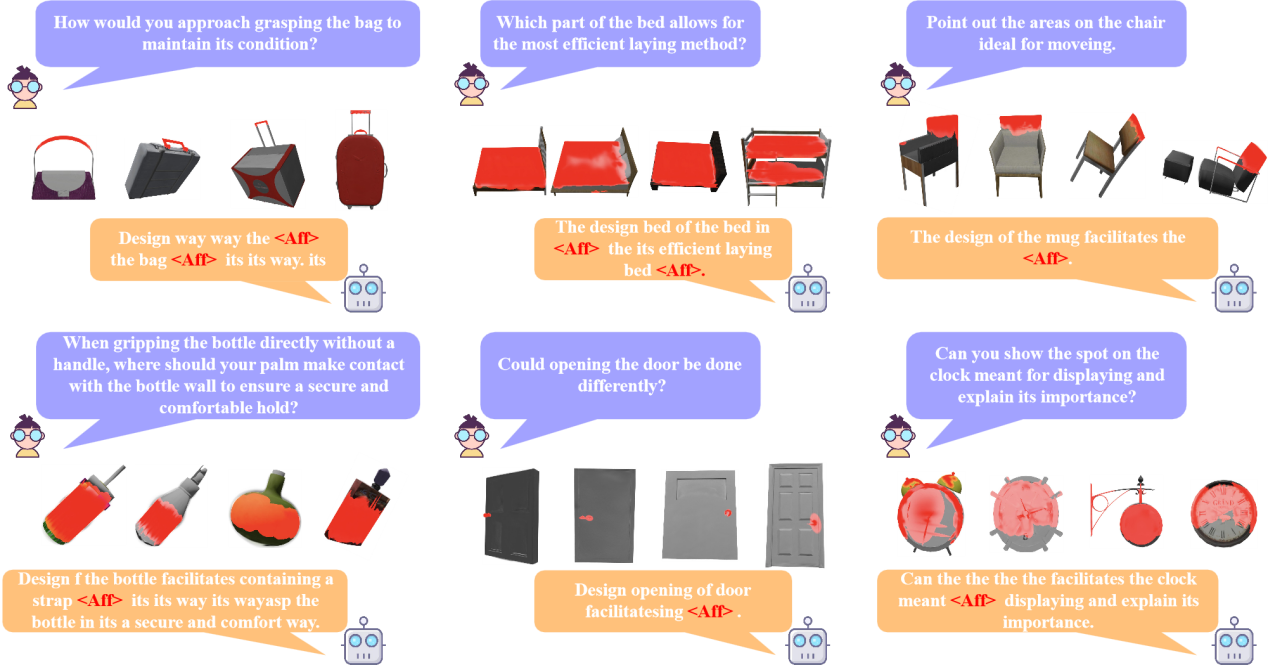

图2. 3DAffordSplat数据集示例图

在具身智能领域,3D可供性(3D Affordance)推理是连接人类指令与物体功能区域的核心技术。它助力智能体理解各类物体的使用方式及交互模式,使智能体能够执行如 “握持杯子把手喝水”“把书放到柜子上”等复杂交互任务。然而,当前主流方法多基于二维图像或稀疏点云,不仅对坐标系变换极为敏感,且由于数据稀疏,难以捕捉像门把手凹槽纹理、刀具刃口倾角等精细结构物件的几何特征,这严重影响了实际应用中的鲁棒性。

3D高斯泼溅(3D Gaussian Splatting, 3DGS)技术采用连续、密集的高斯分布来呈现场景,具备高保真渲染、低计算开销与实时性的优势,能够精准勾勒物体复杂表面特征。针对二维图像和点云在可供性推理方面的局限,3DGS通过连续高斯分布对场景进行建模,可精确重建物体表面微观结构,为可供性推理带来了前所未有的几何保真度。但长期以来,受限于适配其表征形式的大规模数据集的缺失,该技术的潜力未能充分释放,而数据,正是驱动技术突破的关键,是推动发展的核心要素。

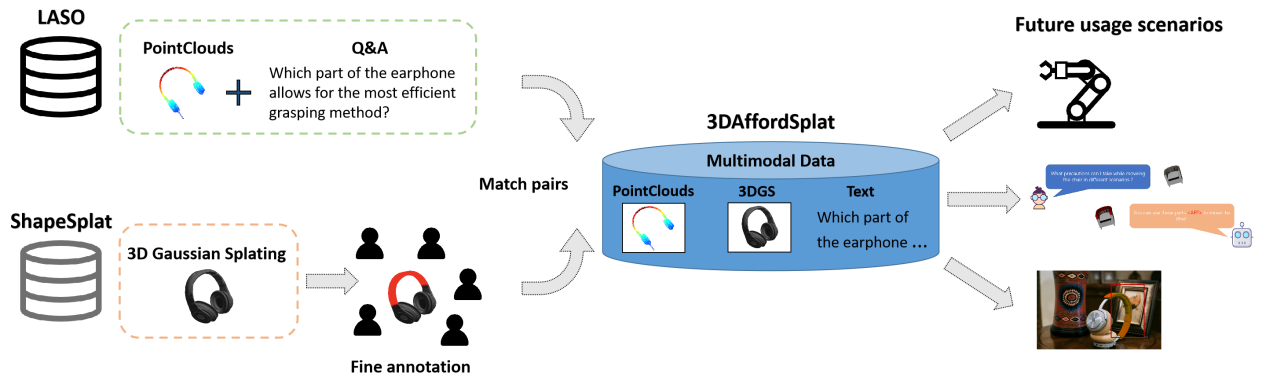

此次发布的3DAffordSplat数据集含有23672个高斯实例与6631个精细人工标注,并整合了8,231个点云对象、对应可供性标注和语言描述。其采集过程如图3所示。

图3.数据集整理流程图

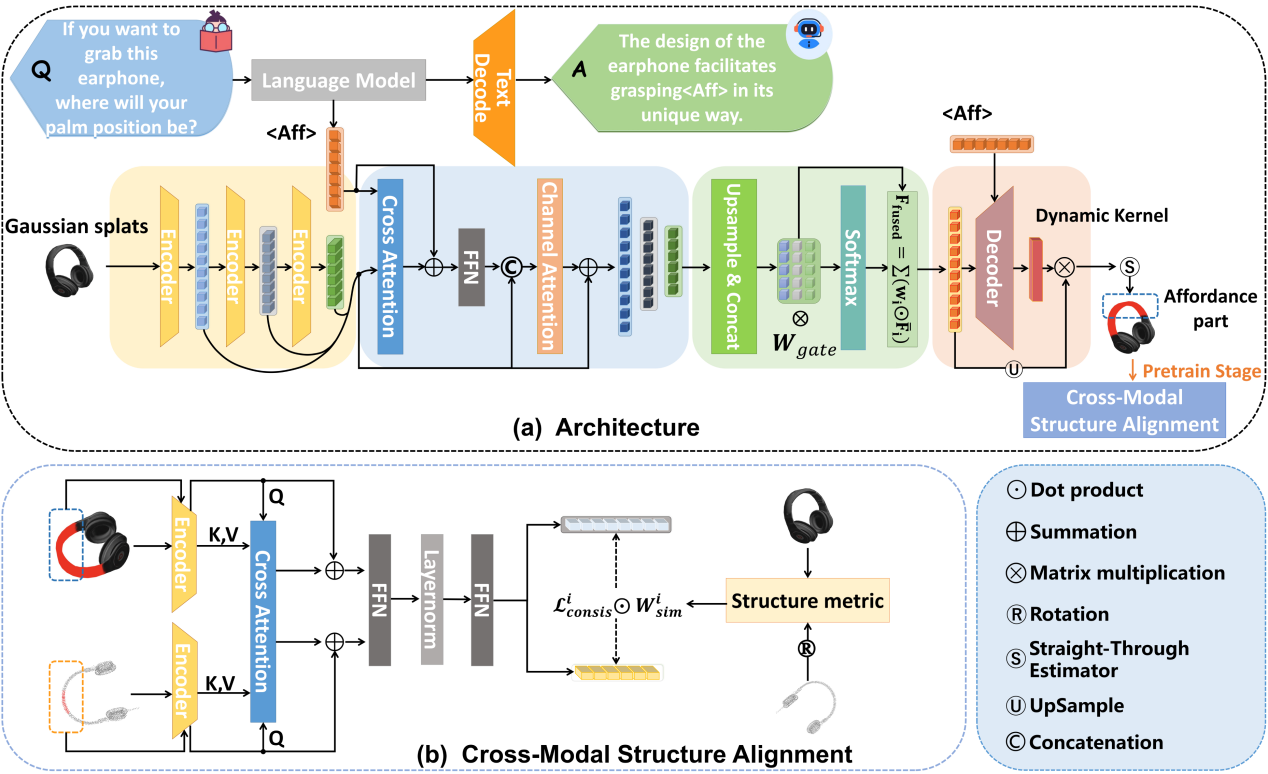

图4. AffordSplat模型框架图

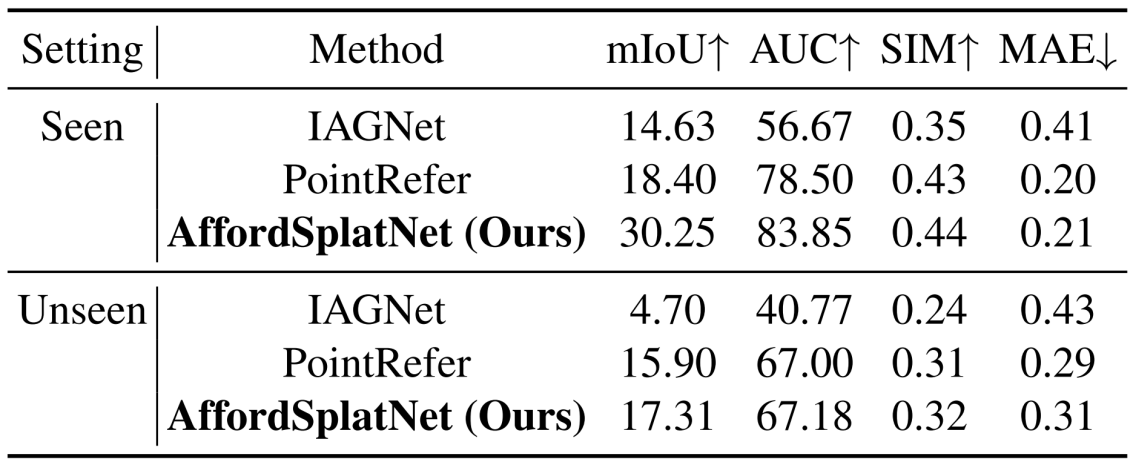

基于3DAffordSplat数据集构建的AffordSplatNet模型是第一个基于3D高斯泼溅的物体可供性推理模型(图4)。该模型创新性地引入点云-3D高斯跨模态结构对齐模块,通过配准点云与高斯表征间的几何一致性,在可供性精细任务中准确率提升显著,如图5所示。

图5. 主要实验结果图

实验表明,这种融合三维高斯与语义推理框架的方法,在已知物体上和未见物体的可供性推理上都能保持交互成功率。

图6. 可视化图

图7. 现实世界迁移可视化图

3DGS的高保真与密集表征优势,为智能体交互提供了更细腻的可供性推理能力,推动了具身智能在真实场景中的实用化进展。3DAffordSplat数据集和AffordSplatNet的发布,将为未来具身机器人执行可供性任务提供可靠数据和解决方案。

数据和模型地址:https://openi.pcl.ac.cn/Code_library_of_IMAEI/3DAffordSplat

相关文献:

[1] Ma, Qi, et al. "Shapesplat: A large-scale dataset of gaussian splats and their self-supervised pretraining." arXiv preprint arXiv:2408.10906 (2024).

[2] Alfassy, Amit, et al. "Laso: Label-set operations networks for multi-label few-shot learning." Proceedings of the IEEE/CVF conference on computer vision and pattern recognition. 2019.

[3] Gao, Xianqiang, et al. "Learning 2d invariant affordance knowledge for 3d affordance grounding." Proceedings of the AAAI Conference on Artificial Intelligence. Vol. 39. No. 3. 2025.